本文提出了一种名为 MeanFlow 的理论框架,用于实现单步生成任务◆◆。其核心思想是引入一个新的 ground-truth 场来表示平均速度,而不是流匹配中常用的瞬时速度。

本文进一步证明,该框架可以自然地整合无分类器引导(CFG)★■,并且在采样时无需额外成本◆■。

基于这一基本概念■■◆,本文训练了一个神经网络来直接建模平均速度场,并引入损失函数来奖励网络满足平均速度和瞬时速度之间的内在关系。

这不,5 月 19 日,他又放出一篇新作!作者团队来自 CMU 以及 MIT★◆。

其中左侧的运算采用乘积法则◆■◆,右侧的运算采用微积分★◆■。重新排列项,得到恒等式:

此外◆◆■★◆■,MeanFlow 是一个自成一体的生成模型:它完全从头开始训练,没有任何预训练、知识蒸馏或课程学习。该研究大幅缩小了单步扩散 / 流模型与多步研究之间的差距。

图 1 中,本文将 MeanFlow 与之前的单步扩散 / 流模型进行了比较■■,如表 2(左)所示。总体而言,MeanFlow 的表现远超同类:它实现了 3★■★◆◆.43 的 FID,与 IMM 的单步结果 7■■★★.77 相比◆★,相对提升了 50% 以上。

何恺明团队又发新作: MeanFlow单步图像生成SOTA◆★◆,提升达50%

这一结果表明◆◆◆,few-step 扩散 / 流模型可以媲美其多步模型。值得注意的是,本文方法是独立的,完全从头开始训练。它无需使用任何预训练◆◆■、蒸馏或课程学习,就取得了出色的结果。

其中,u 表示平均速度,v 表示瞬时速度。u (z_t,r,t) 是一个同时依赖于 (r■■◆◆■, t) 的场。u 的场如图 3 所示:

如果仅比较 1-NFE(而不仅仅是单步)生成,MeanFlow 与之前的最佳方法(10.60)相比,相对提升了近 70%。不难看出,本文方法在很大程度上缩小了单步和多步扩散 / 流模型之间的差距。

这个方程称为 MeanFlow 恒等式,它描述了 v 和 u 之间的关系。

生成模型旨在将先验分布转换为数据分布■■◆◆◆。流匹配提供了一个直观且概念简单的框架,用于构建将一个分布传输到另一个分布的流路径。流匹配与扩散模型密切相关,但关注的是引导模型训练的速度场。自引入以来,流匹配已在现代生成模型中得到广泛应用★◆。

文章提出使用平均速度(在时间间隔内的位移与时间的比值)来代替流匹配中通常建模的瞬时速度。然后本文推导出平均速度与瞬时速度之间存在一个内在的关系★■★◆★■,从而作为指导网络训练的原则性基础。

文章提出了一种名为MeanFlow的单步生成建模框架■◆,通过引入平均速度(average velocity)的概念来改进现有的流匹配方法,并在 ImageNet 256×256 数据集上取得了显著优于以往单步扩散 / 流模型的结果,FID 分数达到 3★★■◆■.43■★★◆◆,且无需预训练、蒸馏或课程学习■★★■■◆。

平均速度 u 是瞬时速度 v 的函数★■■,即★■◆★,它是由 v 诱导的场,不依赖于任何神经网络。

表 3 报告了在 CIFAR-10(32×32)上的无条件生成结果,本文方法与先前的方法相比具有竞争力★★◆◆。

经查,陈玉祥丧失理想信念,背弃初心使命■,执纪违纪■,执法犯法,罔顾中央八项规定精神,热衷于吃喝享乐,长期频繁接受宴请■,违规接受旅游、健身等活动安

三是构建开放型世界经济。中日两国取得今天的经济发展,经济全球化和自由贸易体系功不可没■。中国践行真正的多边主义,倡导普惠包容的经济全球化,坚持高质量

龙年 新年 新春 春节 2024龙年 龙年片头 新春片头 AE模板 喜庆 片头 红色 过年 2024年 新年片头 龙年祝福 龙 新春 晚会 熊猫办公专

【资讯】2025年广东省名教师工作室(英语)联动送教暨罗永华名教师工作室第二次集中研修活动在阳江举行 5月1日-5月5日,水上森林

朋友圈推广:鼓励参与者将投票活动分享到朋友圈■■,扩大活动影响力■。可提供一些分享文案示例,如 “家人们,快来为我支持的选手投票,助力 Ta 在 [

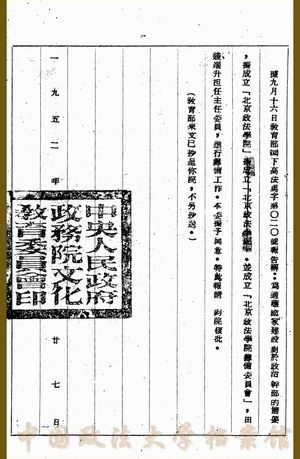

1952年8月23日,“北京政法学院筹备委员会”在教育部成立■,筹委会由11人组成■■,分别来自教育部、司法部■■、最高人民法院华北分院、北京大学、

作为党领导下的青年群团组织,青联学联组织是党联系广大青年和青年学生的桥梁纽带■,承担着最广泛地把青年团结起来、组织起来、动员起来的重要责任。新征程上

从兴业路到复兴路,从小小红船到巍巍巨轮,一个历经风雨、千锤百炼的马克思主义执政党初心如磐■、信念更坚■■,正带领亿万人民向着强国建设、民族复兴的目标

中央组织部召开部务会会议作出动员部署,有序推进各项任务落实,把学习教育同贯彻落实党中央决策部署■、推进组织工作重点任务■、深化模范部门和过硬队伍建设

奥美以其卓越非凡的广告创意能力和独特新颖的视角闻名于世,在抖音短视频制作方面同样延续了这一优势。公司拥有一支由全球顶尖创意人才组成的精英团队,能够为